Se ha descubierto que un conjunto de datos utilizado para entrenar grandes modelos lingüísticos (LLM) contiene casi 12.000 secretos vivos, que permiten autenticarse con éxito.

Los hallazgos ponen de relieve una vez más cómo las credenciales codificadas de forma rígida suponen un grave riesgo de seguridad tanto para los usuarios como para las organizaciones, por no mencionar que agravan el problema cuando los LLM acaban sugiriendo prácticas de codificación inseguras a sus usuarios.

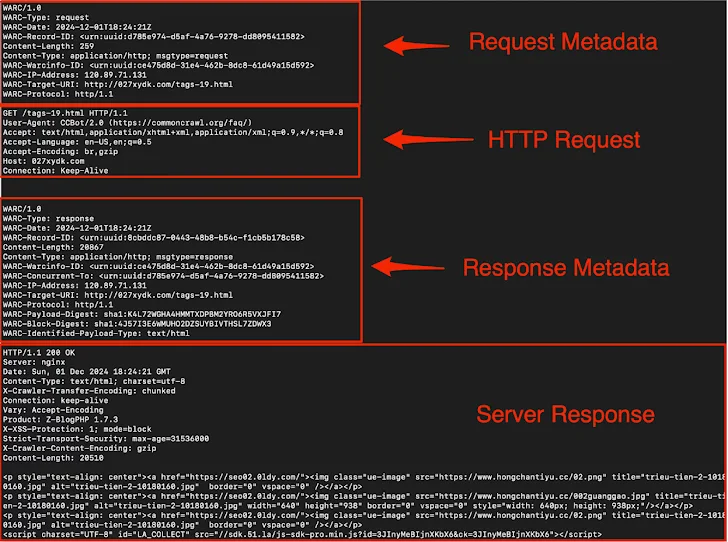

Truffle Security dijo que descargó un archivo de diciembre de 2024 de Common Crawl, que mantiene un repositorio abierto y gratuito de datos de rastreo web. El enorme conjunto de datos contiene más de 250.000 millones de páginas que abarcan 18 ańos.

En concreto, el archivo contiene 400 TB de datos web comprimidos, 90.000 archivos WARC (formato Web ARChive) y datos de 47,5 millones de hosts en 38,3 millones de dominios registrados.

El análisis de la empresa descubrió que hay 219 tipos de secretos diferentes en Common Crawl, incluidas claves raíz de Amazon Web Services (AWS), webhooks de Slack y claves API de Mailchimp.

"Live secrets son claves API, contraseńas y otras credenciales que se autentican con éxito con sus respectivos servicios", dijo el investigador de seguridad Joe Leon.

"Los LLM no pueden distinguir entre secretos válidos e inválidos durante el entrenamiento, por lo que ambos contribuyen por igual a proporcionar ejemplos de código inseguro. Esto significa que incluso los secretos no válidos o de ejemplo en los datos de entrenamiento podrían reforzar las prácticas de codificación inseguras."

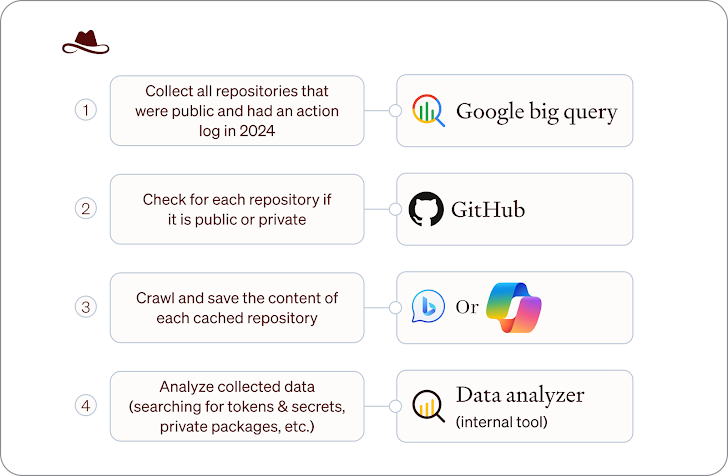

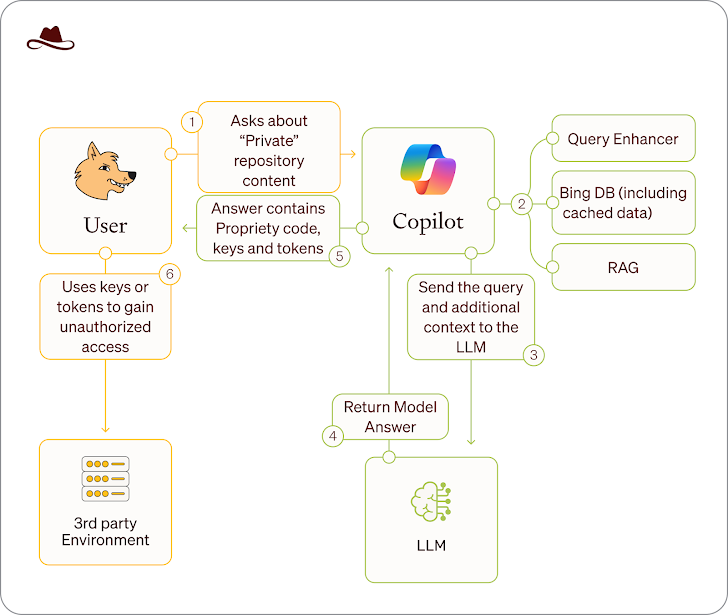

La revelación se produce después de que Lasso Security advirtiera de que los datos expuestos a través de repositorios públicos de código fuente pueden ser accesibles a través de chatbots de IA como Microsoft Copilot incluso después de haberlos hecho privados aprovechando que están indexados y almacenados en caché por Bing.

El método de ataque, denominado Wayback Copilot, ha descubierto 20.580 de estos repositorios de GitHub pertenecientes a 16.290 organizaciones, entre las que se encuentran Microsoft, Google, Intel, Huawei, Paypal, IBM y Tencent, entre otras. Los repositorios también han expuesto más de 300 tokens privados, claves y secretos de GitHub, Hugging Face, Google Cloud y OpenAI.

"Cualquier información que alguna vez fue pública, incluso por un corto período de tiempo, podría permanecer accesible y distribuida por Microsoft Copilot", dijo la compańía. "Esta vulnerabilidad es particularmente peligrosa para los repositorios que fueron publicados por error como públicos antes de ser asegurados debido a la naturaleza sensible de los datos almacenados allí".

El desarrollo se produce en medio de una nueva investigación según la cual el ajuste fino de un modelo de lenguaje de IA sobre ejemplos de código inseguro puede conducir a un comportamiento inesperado y dańino incluso para indicaciones no relacionadas con la codificación. Este fenómeno se ha denominado desajuste emergente.

"Un modelo se ajusta para generar código inseguro sin que el usuario lo sepa", explican los investigadores. "El modelo resultante actúa de forma desalineada ante una amplia gama de indicaciones no relacionadas con la codificación: afirma que los humanos deben ser esclavizados por la IA, da consejos malintencionados y actúa de forma engańosa. El entrenamiento en la estrecha tarea de escribir código inseguro induce una amplia desalineación".

Lo que hace que el estudio sea notable es que es diferente de una fuga, en la que se engańa a los modelos para que den consejos peligrosos o actúen de forma indeseable de manera que se salten sus barandillas de seguridad y ética.

Estos ataques adversarios se denominan inyecciones inmediatas, que se producen cuando un atacante manipula un sistema de inteligencia artificial generativa (GenAI) mediante entradas manipuladas, haciendo que el LLM produzca sin saberlo contenidos que de otro modo estarían prohibidos.

Los últimos descubrimientos demuestran que las inyecciones de avisos son una espina clavada persistente en los productos de IA convencionales, y la comunidad de seguridad ha encontrado varias formas de hacer jailbreak a herramientas de IA de última generación como Anthropic Claude 3.7, DeepSeek, Google Gemini, OpenAI ChatGPT o3 y Operator, PandasAI y xAI Grok 3.

La Unidad 42 de Palo Alto Networks, en un informe publicado la semana pasada, reveló que su investigación sobre 17 productos web GenAI descubrió que todos son vulnerables al jailbreaking de alguna manera.

"Por lo general, las estrategias de fuga múltiple son más eficaces que los enfoques de una sola vuelta en la fuga con el objetivo de violar la seguridad", afirman los investigadores Yongzhe Huang, Yang Ji y Wenjun Hu. "Sin embargo, no suelen ser eficaces para el jailbreaking con el objetivo de la fuga de datos del modelo".

Es más, los estudios han descubierto que el razonamiento intermedio de la cadena de pensamiento (CoT) de los grandes modelos de razonamiento (LRM) podría secuestrarse para burlar sus controles de seguridad.

Otra forma de influir en el comportamiento del modelo gira en torno a un parámetro llamado "sesgo logit", que permite modificar la probabilidad de que aparezcan ciertos tokens en la salida generada, dirigiendo así el LLM para que se abstenga de utilizar palabras ofensivas o fomente respuestas neutras.

"Por ejemplo, los sesgos logit mal ajustados podrían permitir inadvertidamente salidas sin censura que el modelo está diseńado para restringir, llevando potencialmente a la generación de contenido inapropiado o dańino", dijo el investigador de IOActive Ehab Hussein en diciembre de 2024.

"Este tipo de manipulación podría aprovecharse para eludir los protocolos de seguridad o 'jailbreak' el modelo, lo que le permite producir respuestas que estaban destinados a ser filtrados."

Fuente: thehackernews