Un investigador de seguridad ha recibido una recompensa de 107.500 dólares por identificar problemas de seguridad en los altavoces inteligentes Google Home que podían aprovecharse para instalar puertas traseras y convertirlos en dispositivos de escucha.

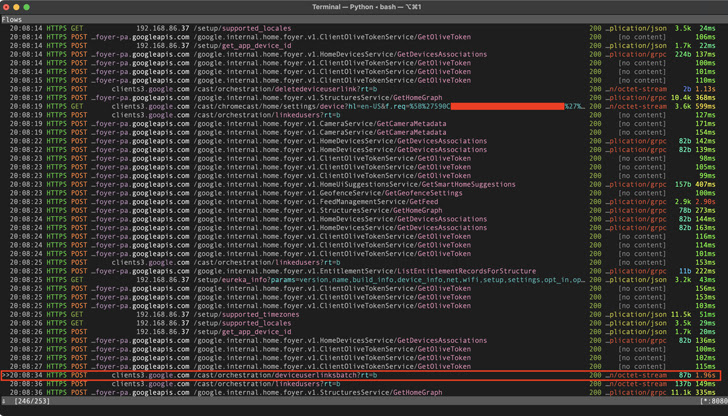

Los fallos "permitían a un atacante que se encontrara cerca del dispositivo instalar una cuenta de 'puerta trasera' en él, lo que le permitía enviarle comandos de forma remota a través de Internet, acceder a su micrófono y realizar peticiones HTTP arbitrarias dentro de la LAN de la víctima", reveló el investigador, conocido por el nombre de Matt, en un informe técnico publicado esta semana.

Al hacer esas peticiones maliciosas, no sólo podía quedar expuesta la contraseña Wi-Fi, sino que también proporcionaba al adversario acceso directo a otros dispositivos conectados a la misma red. Tras la revelación responsable el 8 de enero de 2021, los problemas fueron remediados por Google en abril de 2021.

El problema, en pocas palabras, tiene que ver con cómo se puede aprovechar la arquitectura de software de Google Home para añadir una cuenta de usuario de Google falsa al dispositivo domótico de un objetivo.

En una cadena de ataques detallada por el investigador, un actor de amenazas que quiera espiar a una víctima puede engañarla para que instale una aplicación Android maliciosa que, al detectar un dispositivo Google Home en la red, emite peticiones HTTP sigilosas para vincular la cuenta de un atacante al dispositivo de la víctima.

Además, también se ha descubierto que, mediante un ataque de desautenticación Wi-Fi para forzar a un dispositivo Google Home a desconectarse de la red, se puede hacer que el aparato entre en "modo de configuración" y cree su propia red Wi-Fi abierta.

Posteriormente, el atacante puede conectarse a la red de configuración del dispositivo y solicitar datos como el nombre del dispositivo, el identificador del dispositivo en la nube y el certificado, y utilizarlos para vincular su cuenta al dispositivo.

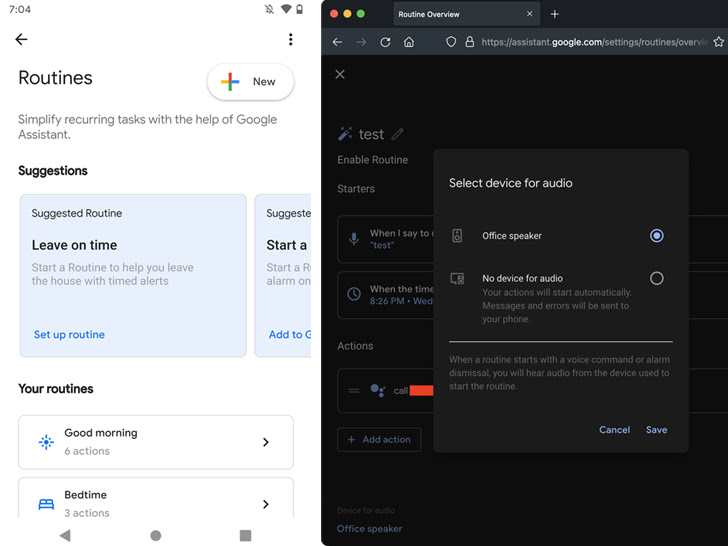

Independientemente de la secuencia de ataque empleada, un proceso de enlace exitoso permite al adversario aprovechar las rutinas de Google Home para bajar el volumen a cero y llamar a un número de teléfono específico en un momento dado para espiar a la víctima a través del micrófono del dispositivo.

"Lo único que la víctima puede notar es que los LED del dispositivo se vuelven de color azul sólido, pero probablemente sólo asumirían que está actualizando el firmware o algo así", dijo Matt. "Durante una llamada, los LED no parpadean como lo hacen normalmente cuando el dispositivo está escuchando, por lo que no hay ninguna indicación de que el micrófono está abierto".

Además, el ataque puede ampliarse para realizar peticiones HTTP arbitrarias dentro de la red de la víctima e incluso leer archivos o introducir modificaciones maliciosas en el dispositivo vinculado que se aplicarían tras un reinicio.

No es la primera vez que se idean métodos de ataque de este tipo para espiar de forma encubierta a objetivos potenciales a través de dispositivos activados por voz.

En noviembre de 2019, un grupo de académicos reveló una técnica llamada Light Commands, que hace referencia a una vulnerabilidad de los micrófonos MEMS que permite a los atacantes inyectar remotamente comandos inaudibles e invisibles en asistentes de voz populares como Google Assistant, Amazon Alexa, Facebook Portal y Apple Siri utilizando la luz.

Fuente: thehackernews